Por Catherine Muñoz, Abogada, LL.M. int. Universidad de Heidelberg. Directora de la consultora IDONEA y de la ONG OPTIA, consultora especializada en materias relacionadas con innovación, ética, regulación de tecnologías y derechos humanos.

Ladrando al árbol equivocado: sobre las metáforas de la IA

Y sin embargo, aunque nuestro cerebro emplea más de neuronas, los representantes de la «inteligencia artificial» tienen la soltura de decir que están a punto de descubrir cómo funciona el cerebro. Dicen: He trabajado en una máquina que funciona tal cual el cerebro. Digo: ¡Oh, felicidades! Y por cierto, ¿cómo funciona el cerebro…? Nadie lo sabe. Entonces, no se puede ni siquiera hacer la comparación. Solo se puede decir que la máquina funciona así y asá, pero no se puede decir que funciona como el cerebro, porque nadie lo sabe. Pero quizás no hace falta saber cómo funciona el cerebro. Tal vez solo sea, como dice el refrán americano, que «estamos ladrando al árbol equivocado» (1)

Heinz von Foerster

Heinz von Foerster, científico del siglo XX, gran exponente de la cibernética y estrecho colaborador de Humberto Maturana, dijo que es común que proyectemos características humanas en cosas o funciones porque nos facilita crear metáforas para comprender y comunicar lo que hacen. Tampoco son metáforas tan complejas: estamos hablando de la cabeza del martillo, la pata de la mesa y la oreja de la taza.

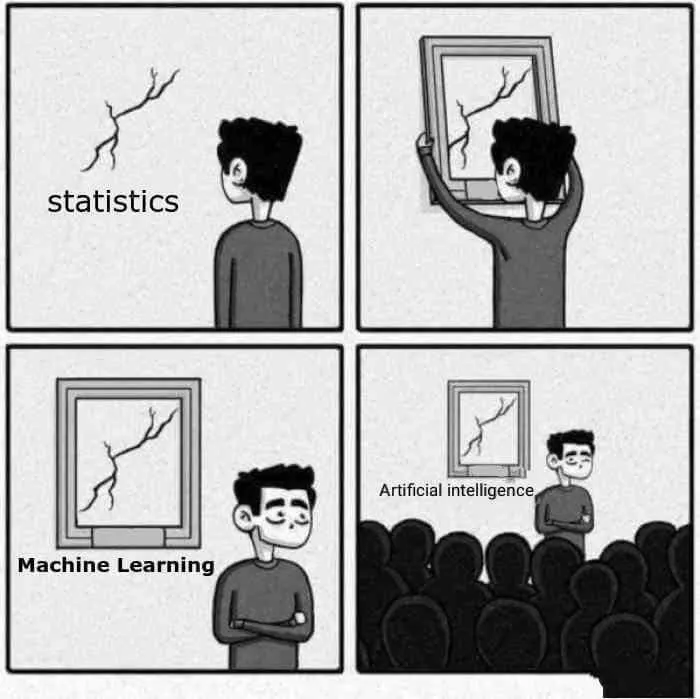

El problema, según Von Foerster, es que se romantizaron funciones intelectuales y se le atribuyeron a las máquinas. Al decir que los computadores «recuperan información» (en realidad, los humanos lo hacen), «resuelven problemas» (nuevamente, los humanos), «aprenden» (no aprenden ni coco), «descubren» (ehm, no) o «demuestran teoremas» (jajajaja... ¡No!) usamos figuras retóricas que trivializan procesos humanos complejos como la conciencia o cognición. Von Foerster agrega que, increíblemente y de forma gradual, se ha empezado a creer por parte de los propios ingenieros que estas funciones intelectuales residen efectivamente en las máquinas (!!!).

En la actualidad, la publicidad y el marketing han sacado provecho de estas metáforas, personificaciones y confusiones (y esto solo va en aumento). No cuestionamos cuando se habla de la capacidad de la inteligencia artificial (IA) para solucionar nuestros graves problemas sociales, predecir comportamientos, prevenir delitos, violencia, etc. usando «sistemas inteligentes», «autónomos», «que se entrenan», «piensan», «aprenden» y pueden «reemplazar y sobrepasar completamente funciones cognitivas humanas».

Lo que estas personificaciones transmiten, es en realidad parte de lo que se denomina inteligencia artificial general (AGI, por sus siglas en inglés), el Santo Grial de la IA y que, por el momento, son solo hipótesis y estudios sobre potenciales inteligencias artificiales a nivel humano y con capacidad de generalización (lo que vemos hasta el cansancio en las películas de ciencia ficción) (2). Las discusiones en torno a la AGI son sobre si podría ser alcanzable en un plazo relativo (durante las próximas cinco décadas o más) o sobre el hecho de que no contaría con las condiciones básicas para materializarse ni ahora ni en el futuro (3). Es decir, la AGI es humo.

Humo y cringe. Mucho cringe.

Lo cierto es que, de acuerdo con el actual estado del arte, lo que existe se denomina IA estrecha (Narrow AI). La IA estrecha puede describir potentes modelos matemáticos, pero estos se traducen en sistemas que resuelven tareas limitadas y específicas, como reconocer objetos o jugar

ajedrez, entre otros. Es decir, la IA estrecha actúa dentro del marco sobre el cual ha sido programada, pero es incapaz de responder en otro contexto, aunque sea levemente diferente (4).

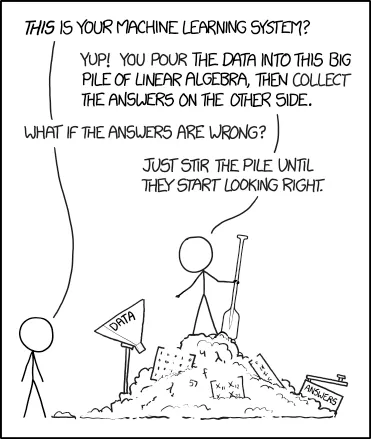

La IA entendida como una rama de las ciencias computacionales –y que, como decíamos, debería denominarse IA estrecha, en vista al estado de la técnica— se ha centrado en la realidad, fuera de laboratorios y universidades, en el aprendizaje automático o machine learning, definido como un proceso automatizado de descubrimiento de correlaciones entre variables en un conjunto de datos, a menudo para hacer predicciones o estimaciones de algún resultado (5).

—¿Este es tu sistema de aprendizaje automático?

—¡Sip! Viertes los datos en esta gran pila de álgebra lineal y luego recoges las respuestas de este otro lado.

—¿Qué pasa si las respuestas son incorrectas?

—Solo se revuelve la pila hasta que comiencen a verse correctas.

Volviendo a Von Foerster, la denominación misma de IA y el hecho de que un tipo de sistema se denomine «aprendizaje automático» son parte de las clásicas metáforas romantizadas de funciones intelectuales. Por eso, es necesario tener presente que «aprendizaje» corresponde a «un cambio u optimización» y no a una mente pequeña dentro de un software y que, por ejemplo, «predicción» es el resultado de correlaciones (que perfectamente podrían no tener ninguna relación con la realidad) y no una predestinación vislumbrada por una inteligencia superior.

Así como estas metáforas suelen ser engañosas, también lo es la afirmación de que un sistema de IA «soluciona problemas»: el sistema no tienen ningún problema que deba ser resuelto porque es solo una herramienta. Y, como cualquier herramienta, es un apoyo para que nosotros solucionemos nuestros problemas, de la misma forma en que un martillo no une dos piezas de madera con un clavo: es el buen uso de la herramienta y del clavo por parte de una persona lo que permite unir las piezas de madera.

Lo anterior parece una trivialidad, pero no lo es: hay una peligrosa sutileza semántica al trasladar la responsabilidad de la acción de la persona a la máquina, ya que nos hace perder de vista el real problema, su dimensión, qué nos motiva a resolverlo y cuál es la solución. Al olvidar que son metáforas de fraccionadas funciones cognitivas, creemos que un sistema de IA está efectivamente solucionando un problema. Pero en realidad está implementando un mecanismo diferente dentro de un marco limitado. Lo que parece una «solución» es una salida de un modelo en base a correlaciones. Luego, podemos percatarnos de que nada de ello guarda relación y sentido con el real problema: hay un error y tratamos de enmendarlo dentro del mismo marco metafórico limitado sin éxito, o podemos aceptar esta supuesta solución como satisfactoria, sin mayor cuestionamiento, perdiendo completamente de vista el problema real. En cualquiera de los dos casos, probablemente, como dice el refrán americano, «estamos ladrando al árbol equivocado».

Jar Jar Binks, ¡guíanos!

Entonces, ¿qué es la IA?

No hay una única definición de IA. Existen diversos conceptos, algunos de ellos caracterizados por elementos de la AGI. Otros conceptos suelen ser específicos a un área de desarrollo determinada, por lo que optar por una definición y generalizarla siempre será una elección reduccionista. Entonces no, no podemos dar una definición de IA.

Pero sí podemos mencionar el elemento principal de esta definición. El primero es que la IA debe ser descrita como sistemas sociotécnicos, que son aquellos que interactúan con entornos sociales y producen resultados socialmente beneficiosos (?). Desde esa perspectiva, los diseños tecnológicos son en esencia, sociotécnicos: no están ligados a objetos específicos, sino a contextos sociales concretos (6).

Desde esta perspectiva sociotécnica, ingenieros, diseñadores, científicos de datos y tomadores de decisiones en general deben pasar de la búsqueda de una solución técnica a la ponderación de diferentes marcos para anticipar y responder a las tensiones, incertidumbres y conflictos, en base a consideraciones como (6) si el sistema es adecuado para una situación particular o existen otras soluciones que consideren el contexto social y político. Esto último se recomienda con el objeto de evitar el famoso tecnosolucionismo, es decir, que se afecte al contexto social de forma predecible, pero sin producir ningún beneficio al implementar un sistema o, incluso, produciendo un perjuicio.

¿Qué es un algoritmo?

A menudo solemos emplear la expresión «IA» y «algoritmo» indistintamente. En su definición generalizada, un algoritmo es un conjunto de reglas que definen con precisión una secuencia de operaciones (7). Es decir, IA y algoritmo no son sinónimos: un algoritmo puede ser una receta de cocina con pasos detallados hasta complejas reglas matemáticas. Pero, ¿es la IA es un algoritmo?

Revisemos el funcionamiento básico de un machine learning con un ejemplo de un aprendizaje supervisado: se programa un algoritmo para obtener un modelo optimizado que dé respuesta a una tarea determinada a partir de la identificación de patrones de un conjunto de datos previamente etiquetados, training data o datos de entrenamiento. El algoritmo estima las tasas de error de cada modelo aplicando otro conjunto externo de datos, los validation set. Si el modelo tiene un rendimiento satisfactorio, termina el entrenamiento. Si el rendimiento no produce suficientes resultados, se modifica el modelo y se repite el proceso. El algoritmo selecciona el modelo que mejor describe las características y tendencias a partir de los conjuntos de datos de entrenamiento y validación. Finalmente, mediante un tercer conjunto de datos llamados test set o datos de pruebas, se calcula el error de predicción generalizado, lo que queda a disposición del usuario final para una evaluación adecuada del nivel predictivo o análisis del modelo.

De la descripción anterior, podemos distinguir tres elementos esenciales en un sistema de IA: (a) los datos, (b) un algoritmo y (c) un modelo, esta distinción es relevante ya que permite explicar con prioridad y claridad en distintos tipos sesgos producidos. También la distinción es importante ya que permite diferenciar aquellas características, en particular, de los modelos que son límites técnicos a los mismos, siendo factores desencadenantes de determinados sesgos.

En el ámbito de los datos podemos encontrar, entre muchos otros, el sesgo de recopilación, que ocurre por la inferencia de sesgos incrustados en los mismos datos. También existe el sesgo de representación, que se presenta cuando un sistema de IA es entrenado con datos de una parte limitada de una población que no es representativa de la totalidad: esto suele subrrepresentar, usualmente, a grupos vulnerables.

Los modelos, por su parte, contienen la información estructurada resultante de la etapa de entrenamiento («aprendidas» por el algoritmo de entrenamiento) que definen una secuencia de operaciones. Los sesgos pueden ser provocados de forma intencional, por malas decisiones en su diseño o como consecuencia de sus propios límites técnicos (8), ya que son modelos matemáticos de carácter cuantitativo. Esto significa que deben reducir los datos, porque son incapaces de analizar todas las variables presentes en construcciones sociales: por ello, son bastante frecuentes los impactos negativos causados por un resultado sesgado de los modelos.

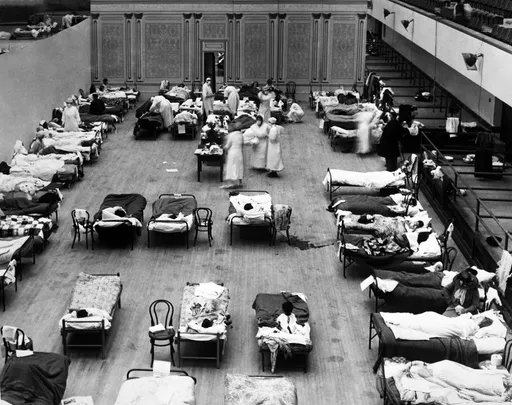

Sin perjuicio de que los impactos negativos en las personas se expresan en los modelos, los principales tipos de algoritmos de machine learning que estructuran dichos modelos tienen bastante que decir. El algoritmo de regresión lineal fue desarrollado por los eugenistas del siglo XX y uno de los algoritmos más usados en machine learning, de agrupamiento jerárquico o clúster, deriva de un modelo de segregación habitacional racista de los años 1950 (9).

En particular, estos algoritmos tienen una tendencia o preferencia hacia la optimización de un resultado predefinido y, en consecuencia, generan como contrapartida exclusión que repercute en perjuicios sobre las personas, usualmente sobre grupos históricamente vulnerados y oprimidos.

Si bien, según la definición general, un modelo también sería un algoritmo, no es correcto hablar indistintamente de sistema de IA y algoritmos, ya que además de ser confuso para explicar sus componente esenciales e impactos, tiene una trampa y la misma sutileza semántica mencionada en los párrafos anteriores. Al hablar de «algoritmos», queda implícita la idea de que no existen personas responsables detrás, por lo que cualquier perjuicio causado al aplicar los resultados del algoritmo sería responsabilidad de un conjunto de complejas reglas matemáticas aprendidas de forma automatizada: es decir, no habría ningún responsable particular. Y esto, como ya se ha señalado, es totalmente irreal: la IA es un sistema sociotécnico y, como tal, siempre hay alguien responsable o irresponsable detrás.

¿Para quién es la IA?

Todos hemos escuchado sobre los grandes avances y beneficios de la IA. Pero, ¿nos hemos preguntado si estos avances y beneficios son para todos? ¿Para quién es la inteligencia artificial? ¿A quién realmente beneficia?

Quizás sea el momento de hacerse esas preguntas. O quizás debamos dejarlas abiertas, dependiendo de su grado de optimismo. Lo que sí podemos afirmar es para quién no es la IA.

La IA no es para grupos vulnerables, históricamente excluidos, marginados. Y, probablemente, no lo sea para la gran mayoría de nosotros. Esto lo explicaremos en la segunda parte de este artículo hablando sobre dos tipos de aplicaciones de IA: (a) los sistemas de reconocimiento facial —y el resurgimiento de la oscura pseudociencia racista que arrastra—; y (b) los sistemas de toma de decisiones automatizadas que, al ser usados como medio para resolver problemas sociales, usualmente amplifican y perpetúan injusticias históricas sobre grupos vulnerables.

Referencias

1.

H. Von Foerster, Understanding understanding: Essays on cybernetics and cognition. Springer Science & Business Media, 2007.

2.

B. Goertzel, «Artificial general intelligence: concept, state of the art, and future prospects», J. Artif. Gen. Intell., vol. 5, n.o 1, p. 1, 2014.

3.

R. Fjelland, «Why general artificial intelligence will not be realized», Humanit. Soc. Sci. Commun., vol. 7, n.o 1, pp. 1-9, 2020.

4.

G. Marcus, «The next decade in ai: four steps towards robust artificial intelligence», ArXiv Prepr. ArXiv200206177, 2020.

5.

M. Broussard, Artificial Unintelligence: How Computers Misunderstand the World. MIT Press, 2018.

6.

A. D. Selbst, D. Boyd, S. A. Friedler, S. Venkatasubramanian, y J. Vertesi, «Fairness and abstraction in sociotechnical systems», en Proceedings of the conference on fairness, accountability, and transparency, 2019, pp. 59-68.

7.

«What is an “algorithm”? It depends whom you ask», MIT Technology Review. https://www.technologyreview.com/2021/02/26/1020007/what-is-an-algorithm/ (accedido 22 de febrero de 2022).

8.

M. Malik, «A Hierarchy of Limitations in Machine Learning», ArXiv200205193 Cs Econ Math Stat, feb. 2020, Accedido: 8 de marzo de 2021. [En línea]. Disponible en: http://arxiv.org/abs/2002.05193

9.

«Homophily: The Urban History of an Algorithm - Architecture - e-flux». https://www.e-flux.com/architecture/are-friends-electric/289193/homophily-the-urban-history-of-an-algorithm/ (accedido 22 de febrero de 2022).

_(1).jpeg&blockId=e5dde283-d3d7-422c-a101-fb6e8f94f806&width=3600)

_(1).jpeg&blockId=e5dde283-d3d7-422c-a101-fb6e8f94f806&width=512)