No tenemos la más pálida idea de qué es inteligencia, pero tenemos personalidad para ponerle como nombre “Inteligencia Artificial” a un programa de computador

1.

No existe "Inteligencia Artificial", pero bue, el nombre pegó

2.

Haciendo predicciones a punta de patrones

3.

Algo de historia sobre los orígenes de la IA

4.

IA Predictiva

5.

IA Generativa: No es más que un teclado predictivo en cocaína, y sin teclado

6.

Problemas: La gente cree que es un "buscador", o que es "inteligente"

7.

Problemas 2: Los que quieren hacer plata fácil a costa de pasar por encima de la ética y justicia

8.

Qué podemos hacer?

9.

Un mensaje pa los haters y succionadores de pico de Elon Musk y su pandilla

Tal como lo contamos en este artículo, y en este artículo, uno de los problemas con los que nos vamos a encontrar cada vez que hablemos de este tipo de tecnologías es un problema de semántica y de metáforas.

SALAMI

A lo largo del último siglo se han desarrollado métodos matemáticos y estadísticos para "predecir" el valor de un elemento en una lista.

Por ejemplo, nosotros como humanos, al ser presentados con esta lista: 2, 4, 6, 8, 10, X

Podemos usar nuestro razonamiento y lógica para determinar que hay un patrón y a partir de eso, calcular el valor de X.

Con estadística se puede hacer una regresión lineal, y poder usarla en forma general para "predecir" el valor que tendrá esa lista en N elementos más.

Si tiramos algo más complejo, supongamos una lista que dice:

Lunes: 100

Martes: 50

Miércoles: 0

Jueves: 80

Viernes: 100

Sábado: 90

Domingo: X

De una forma similar a la anterior, nuestro cerebro trata de buscar un patrón, no lo encuentra en forma pura, pero si detecta un comportamiento que le hace sentido en el contexto de sus experiencias y relación con la realidad.

Si le pasamos esto a un sistema estadístico, es posible que trate de hacer una regresión, o un ajuste cuadrático, o cualquiera de esas cosas, y lograr un resultado que no sea del todo insensato.

Hasta ahí estamos hablando de métodos super conocidos, donde sabemos lo que ocurre en cada paso del proceso de cálculo. Podemos hacerlo a mano, podemos ver los resultados intermedios, podemos trazar de dónde salió todo.

Alejandro  , [23-04-23 11:22]

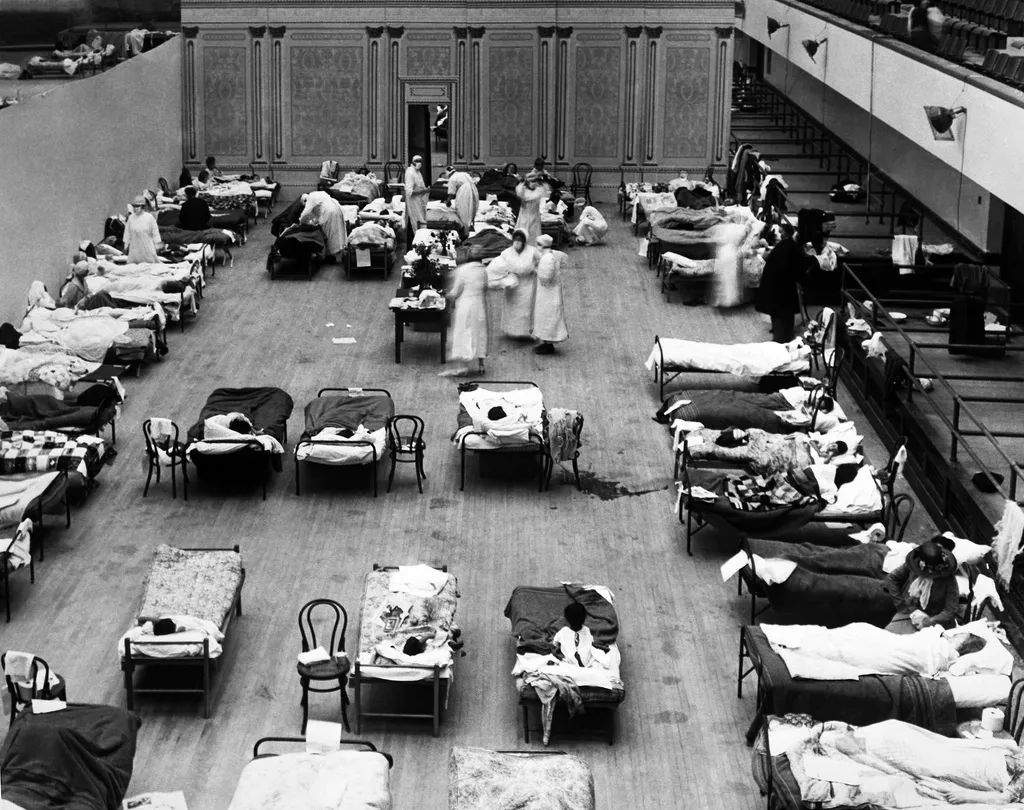

Pero, en los 50's y 60's se desarrollaron teorías matemáticas en torno a métodos que no son deterministas. Donde no se tiene el detalle del paso a paso de como se hacen los cálculos, y donde se usa el azar para generar sutiles variaciones en el cálculo para probar si mejora o empeora con esa introducción de caos.

, [23-04-23 11:22]

Pero, en los 50's y 60's se desarrollaron teorías matemáticas en torno a métodos que no son deterministas. Donde no se tiene el detalle del paso a paso de como se hacen los cálculos, y donde se usa el azar para generar sutiles variaciones en el cálculo para probar si mejora o empeora con esa introducción de caos.

Alejandro  , [23-04-23 11:24]

Estos métodos fueron llamados colectivamente "Inteligencia Artificial", porque se podían usar para llegar a un resultado SIN decirle qué método usar, es decir, le dábamos los datos de entrada, algunos ejemplos pasados de lo que debía pasar, y estos métodos "encontraban" una forma de acercarse a los resultados que le estaban pidiendo, a partir de los datos históricos suministrados.

, [23-04-23 11:24]

Estos métodos fueron llamados colectivamente "Inteligencia Artificial", porque se podían usar para llegar a un resultado SIN decirle qué método usar, es decir, le dábamos los datos de entrada, algunos ejemplos pasados de lo que debía pasar, y estos métodos "encontraban" una forma de acercarse a los resultados que le estaban pidiendo, a partir de los datos históricos suministrados.

Alejandro  , [23-04-23 11:24]

Dentro de estos métodos están las Redes Neuronales, los Algorítmos Genéticos y la lógica difusa, entre otros menos populares.

, [23-04-23 11:24]

Dentro de estos métodos están las Redes Neuronales, los Algorítmos Genéticos y la lógica difusa, entre otros menos populares.

Alejandro  , [23-04-23 11:26]

No fue hasta hace unos 10 años que empezamos a tener máquinas y lenguajes que fueran eficientes para manejar grandes cantidades de datos en memoria para poder hacer este ejercicio de "prueba y error" para encontrar resultados en forma rápida.

, [23-04-23 11:26]

No fue hasta hace unos 10 años que empezamos a tener máquinas y lenguajes que fueran eficientes para manejar grandes cantidades de datos en memoria para poder hacer este ejercicio de "prueba y error" para encontrar resultados en forma rápida.

Alejandro  , [23-04-23 11:30]

Se inició tratando de hacer predicciones de cosas complejas, por ejemplo, de cosas que dependieran de decenas o cientos de variables. Se alimentó todo esto en una red neuronal (que no son nada más que neuronas: pedacitos de memoria en el computador que reciben un valor, lo multiplican por otro, y mandan el resultado a la siguiente neurona). Estas redes neuronales, a punta de prueba y error, lograban predecir resultados para sistemas con cientos de variables, cosa que nosotros, humanos, a punta de papel, lápiz, excel y ecco, no podríanos hacer.

Algo terrible empezó a pasar ahí: las metáforas que se utilizaban se popularizaron, y la gente empezó a creer que las redes neuronales tenían neuronas (como las humanas), que la Inteligencia Artificial era Inteligente, y que las Predicciones eran el resultado del razonamiento y lógica.

, [23-04-23 11:30]

Se inició tratando de hacer predicciones de cosas complejas, por ejemplo, de cosas que dependieran de decenas o cientos de variables. Se alimentó todo esto en una red neuronal (que no son nada más que neuronas: pedacitos de memoria en el computador que reciben un valor, lo multiplican por otro, y mandan el resultado a la siguiente neurona). Estas redes neuronales, a punta de prueba y error, lograban predecir resultados para sistemas con cientos de variables, cosa que nosotros, humanos, a punta de papel, lápiz, excel y ecco, no podríanos hacer.

Algo terrible empezó a pasar ahí: las metáforas que se utilizaban se popularizaron, y la gente empezó a creer que las redes neuronales tenían neuronas (como las humanas), que la Inteligencia Artificial era Inteligente, y que las Predicciones eran el resultado del razonamiento y lógica.

Alejandro  , [23-04-23 11:30]

Nada de eso es verdad

, [23-04-23 11:30]

Nada de eso es verdad

Alejandro  , [23-04-23 11:31]

Son números multiplicándose con otros números para dar otros números que se acercan a lo que nosotros estimamos como el resultado correcto.

, [23-04-23 11:31]

Son números multiplicándose con otros números para dar otros números que se acercan a lo que nosotros estimamos como el resultado correcto.

Alejandro  , [23-04-23 11:32]

Alguien pensó:

Oye, y si en vez de predecir el número de una secuencia, predecimos la siguiente palabra de un texto?

, [23-04-23 11:32]

Alguien pensó:

Oye, y si en vez de predecir el número de una secuencia, predecimos la siguiente palabra de un texto?

Alejandro  , [23-04-23 11:33]

Así, si ponías una lista diciendo "uno, dos, tres, cuatro, X", estas redes neuronales (que no tienen idea de lo que significa cada una de esas palabras), podían (basadas en sus datos de entrenamiento), llegar a la conclusión de que X es "cinco".

, [23-04-23 11:33]

Así, si ponías una lista diciendo "uno, dos, tres, cuatro, X", estas redes neuronales (que no tienen idea de lo que significa cada una de esas palabras), podían (basadas en sus datos de entrenamiento), llegar a la conclusión de que X es "cinco".

Alejandro  , [23-04-23 11:34]

Nuevamente, no es inteligencia, es la capacidad de un método para llegar a resultados que nosotros consideramos correctos.

, [23-04-23 11:34]

Nuevamente, no es inteligencia, es la capacidad de un método para llegar a resultados que nosotros consideramos correctos.

Alejandro  , [23-04-23 11:37]

Pero alguien dijo: Oye, y si como datos de entrenamiento le metemos TODO EL CONTENIDO ESCRITO QUE PODAMOS CONSEGUIR?, y que las columnas con variables sean muchas, onda MILES DE MILLONES?

Estamos hablando que esas columnas contienen: lenguaje, cantidad de vocales, cantidad de consonantes, palabra anterior, palabra siguiente, palabra subsiguiente, palabra con la que inicia la frase, palabra con la que termina la frase, cantidad de números en la fráse, etc, etc, etc... 5mil millones de columnas para el entrenamiento.

, [23-04-23 11:37]

Pero alguien dijo: Oye, y si como datos de entrenamiento le metemos TODO EL CONTENIDO ESCRITO QUE PODAMOS CONSEGUIR?, y que las columnas con variables sean muchas, onda MILES DE MILLONES?

Estamos hablando que esas columnas contienen: lenguaje, cantidad de vocales, cantidad de consonantes, palabra anterior, palabra siguiente, palabra subsiguiente, palabra con la que inicia la frase, palabra con la que termina la frase, cantidad de números en la fráse, etc, etc, etc... 5mil millones de columnas para el entrenamiento.

Alejandro  , [23-04-23 11:38]

Al alimentar una red neuronal con esto, obtienes un predictor de texto megapoderoso. Una máquina que es capaz de generar texto que esté bien escrito y que tenga coherencia (aunque la máquina no tiene idea de lo que significa nada de eso).

, [23-04-23 11:38]

Al alimentar una red neuronal con esto, obtienes un predictor de texto megapoderoso. Una máquina que es capaz de generar texto que esté bien escrito y que tenga coherencia (aunque la máquina no tiene idea de lo que significa nada de eso).

Alejandro  , [23-04-23 11:39]

A estas redes neuronales entrenadas con miles de millones de variables, y con cientos de millones de textos en muchos idiomas, formatos y demás, empezaron a ser conocidas como LLM: Large Language Models.

, [23-04-23 11:39]

A estas redes neuronales entrenadas con miles de millones de variables, y con cientos de millones de textos en muchos idiomas, formatos y demás, empezaron a ser conocidas como LLM: Large Language Models.

Alejandro  , [23-04-23 11:40]

Cada vez que ustedes le preguntan algo a un LLM, no les va a decir "la verdad", un LLM no tiene idea de lo que es verdad o no, lo que es sensato o no, lo que les va a decir es la secuencia de palabras que estadísticamente sean más probables de ir juntas como continuación a lo que ustedes escribieron como pregunta.

, [23-04-23 11:40]

Cada vez que ustedes le preguntan algo a un LLM, no les va a decir "la verdad", un LLM no tiene idea de lo que es verdad o no, lo que es sensato o no, lo que les va a decir es la secuencia de palabras que estadísticamente sean más probables de ir juntas como continuación a lo que ustedes escribieron como pregunta.

Alejandro  , [23-04-23 11:44]

Como era "fome" que siempre respondiera lo mismo, los autores de los LLM introdujeron el concepto de "Temperatura" del modelo. Baja temperatura: el modelo escoge siempre las secuencia más probable. A mayor temperatura, el modelo añade un poco de azar en la selección de la secuencia de palabras, y así aparecen variaciones. La gente vio esto y le llamó "Creatividad" de la "Inteligencia Artificial". Nuevamente, no hay creatividad acá, es un método estadístico sumado a un generador de aleatoriedad, que da como resultado una secuencia de texto que nos parece sensata.

, [23-04-23 11:44]

Como era "fome" que siempre respondiera lo mismo, los autores de los LLM introdujeron el concepto de "Temperatura" del modelo. Baja temperatura: el modelo escoge siempre las secuencia más probable. A mayor temperatura, el modelo añade un poco de azar en la selección de la secuencia de palabras, y así aparecen variaciones. La gente vio esto y le llamó "Creatividad" de la "Inteligencia Artificial". Nuevamente, no hay creatividad acá, es un método estadístico sumado a un generador de aleatoriedad, que da como resultado una secuencia de texto que nos parece sensata.

Alejandro  , [23-04-23 11:45]

Está lejos de ser un oráculo, o un sistema perfecto, a menos que busques un sistema que escriba cosas que vayan bien con lo que le pasaste como entrada, como "Prompt".

, [23-04-23 11:45]

Está lejos de ser un oráculo, o un sistema perfecto, a menos que busques un sistema que escriba cosas que vayan bien con lo que le pasaste como entrada, como "Prompt".

Alejandro  , [23-04-23 11:46]

Entonces

, [23-04-23 11:46]

Entonces

Alejandro  , [23-04-23 11:49]

Volviendo a lo que le pasó a @CarrieMathison, que le decía cosas bacanes, pero le referenciaba artículos ficticios: El sistema, a punta de todos los textos que usó para su entrenamiento, genera textos que son consistentes con tu pregunta, y con lo que tiene en su "memoria", y como es esperable que cada una de esas declaraciones tenga una fuente, el sistema predice cada una de las palabras que se esperan en una referencia científica... Pero es una predicción cosmética (todo es cosmético acá), muy bien conformada como referencia, pero apuntando a papers que no existen, creados por investigadoras no no existen, en páginas que no existen, etc.

, [23-04-23 11:49]

Volviendo a lo que le pasó a @CarrieMathison, que le decía cosas bacanes, pero le referenciaba artículos ficticios: El sistema, a punta de todos los textos que usó para su entrenamiento, genera textos que son consistentes con tu pregunta, y con lo que tiene en su "memoria", y como es esperable que cada una de esas declaraciones tenga una fuente, el sistema predice cada una de las palabras que se esperan en una referencia científica... Pero es una predicción cosmética (todo es cosmético acá), muy bien conformada como referencia, pero apuntando a papers que no existen, creados por investigadoras no no existen, en páginas que no existen, etc.

Referencias

1.

a

2.

b

3.

c

_(1).jpeg&blockId=e5dde283-d3d7-422c-a101-fb6e8f94f806&width=1024)