Por estos días ha aparecido en la prensa internacional un estudio que indicaría que las mujeres embarazadas que se exponen al wifi o teléfonos celulares tendrían 2 veces más riesgo de sufrir un aborto.

Wow, esto es tremendo y va en contra de todos los estudios serios al respecto. Por eso, cuando leímos esto en prensa nos acordamos de las palabras de Carl Sagan: «Afirmaciones extraordinarias requieren evidencias extraordinarias». Entonces, supusimos que este podría ser el típico caso de descubrimiento asombroso que finalmente no lo es e imaginamos uno de estos posibles escenarios:

•

•

Duh. Seguro es un estudio en ratas.

•

Habrá que ver qué metodología usaron.

Pues bien, gran sorpresa!

El paper estaba esquivo; obviamente costó encontrarlo pues en general la prensa no pone los vínculos directos de los estudios, lo que hace dudar de que los hayan leído y alimenta el prejuicio de que solo copian la nota de prensa de la institución. Finalmente lo encontramos y... ¡SHOCK GENUINO! Estaba publicado en el Scientific Reports uno de los Journal Open Access de la Nature (GLUP).

Bueno vamo a calmarno dijimos… Seguro es un estudio en ratitas.

Listo… Nos dispusimos a leer esto con mucha calma pues la ocasión lo ameritaba. Las personas que nos dedicamos a la ciencia suelen ser sapas curiosas por naturaleza. Si un artículo tiene el potencial de hacer cambiar nuestra perspectiva de algo tan popular como el wifi o el teléfono celular basándose en un potencial riesgo sanitario, pues merece concentración y suspender por un momento nuestros sesgos personales (todos tenemos sesgos… Las personas de ciencia no somos una estéril barra de carbono).

Y bueno... Al principio, el estudio parece bien ejecutado. Una buena descripción en la introducción, aunque no hay muchas citas bibliográficas (solo 20 en todo el texto... Para algo que nos puede hacer cambiar nuestra forma de pensar y abordar estos objetos tan cotidianos, parecen pocas). De hecho, de las referencias que respaldaban esta afirmación, destacan en el texto una de ellas varias veces. Resultó ser una cita del mismo autor del paper. Esto no tiene nada de malo, pero llama la atención la autocita recurrente.

Luego, como bien saben, lo único más importante a la hora de analizar un paper es la metodología <3. Así que ahí vamos.

Metodología

La población en estudio eran mujeres mayores de edad, embarazadas y atendidas en el seguro de salud de USA Kaiser Permanente, que vivían en el Área de la Bahía de San Francisco.

Acá empieza lo curioso. El estudio fue aprobado por el Comité de Ética de Kaiser Permanente. Es curioso porque es como si Másvida (#RIP) haya hecho un estudio y lo hubiera aprobado el comité de ética Másvida... Raro, porque la aprobación debe ser entregada por un organismo independiente. Pero bueno, demos el beneficio de la duda, no seamos tan puristas.

En el muestreo, sobrerrepresentaron a las mujeres que habían tenido dos o más abortos espontáneos en el pasado. La sobrerrepresentación se hace y está bien, cuando se explica y justifica esta decisión. Pero esto no ocurre en el artículo y queda la impresión de que se manipula el diseño sin respetar la pregunta original. Tampoco en ninguna parte del artículo nos indican la estrategia de cálculo muestral. Este es un punto clave para analizar los resultados y entonces nos encontramos leyendo a ciegas, confiando que lo hicieron bien (emoji escéptico).

Aghh!! ¿Leyó bien? ¿Qué puse ahí? Correcto: escéptico, no Decepticon.

Uhmmm. Ok. GRACIAS. ¿Continuemos por favor?

Nos dicen que 1.627 mujeres embarazadas fueron elegibles para el estudio, y 1.054 aceptaron participar (del resumen sabemos que sólo 913 embarazadas fueron realmente estudiadas).

Las mujeres que aceptaron participar tenían que llevar consigo un instrumento para medir la exposición al campo magnético durante 24 horas. Luego se enredan bastante en indicarnos que analizarán los datos sólo de los «días típicos», pero nunca nos explican qué es para ellos un «día típico». Solo nos dicen que «analizarán los datos de los días que reflejen patrones de actividad típica de trabajo y actividades recreativas durante el embarazo».

Quienes hacemos investigación científica y llevamos un buen tiempo haciendo estudios, analizando datos y haciendo lectura crítica de artículos sabemos lo siguiente:

1.

Si usted quiere incorporar una variable que parece contraintuitiva (¿por qué dejar de lado los «días atípicos»?), debe definirla muy bien, o nadie entenderá qué busca usted con esa restricción de datos. Suena a torturar el dato. (#LoDijeYQué)

2.

Una de las características de la ciencia y uno de los objetivos más importantes de publicar es que su investigación pueda ser replicada. ¿Cómo alguien puede replicar algo sin conocer las variables básicas?

El instrumento medía el campo magnético de todas las fuentes durante todo el día y noche. Se excluyeron 31 mujeres que no lograron llevar el instrumento como se les indicó y 107 mujeres que no lograron obtener datos mayores al 90% de la medición diaria. Nos aclaran que la eliminación de esos participantes se hizo desconociendo el resultado. Esto es muy bueno y se agradece.

Luego informan que usarán la recomendación de estudios previos para enfocarse en buscar la asociación con la exposición alta a campo magnético. Para ello, separarán la muestra en 4 grupos de exposición, agrupándolos en 0 (baja exposición o primer cuartil) y 1 (alta exposición o cuartiles 2, 3 y 4). Esta división nos pareció extraña. Muy forzada. ¿Por qué no separarlos en cuartiles 1-2 versus 3-4, o en 1-2-3 versus 4? Entonces revisamos las dos referencias que recomendaban hacer esto: una de ellas era la autocita y la otra un estudio también realizado por Kaiser Permanente (curioso).

¿Por qué?

Nos explican de nuevo que usarán solo los datos de días típicos y esta vez. ¡Con una referencia a un estudio previo! Y, como puede imaginarlo, era la autocita.

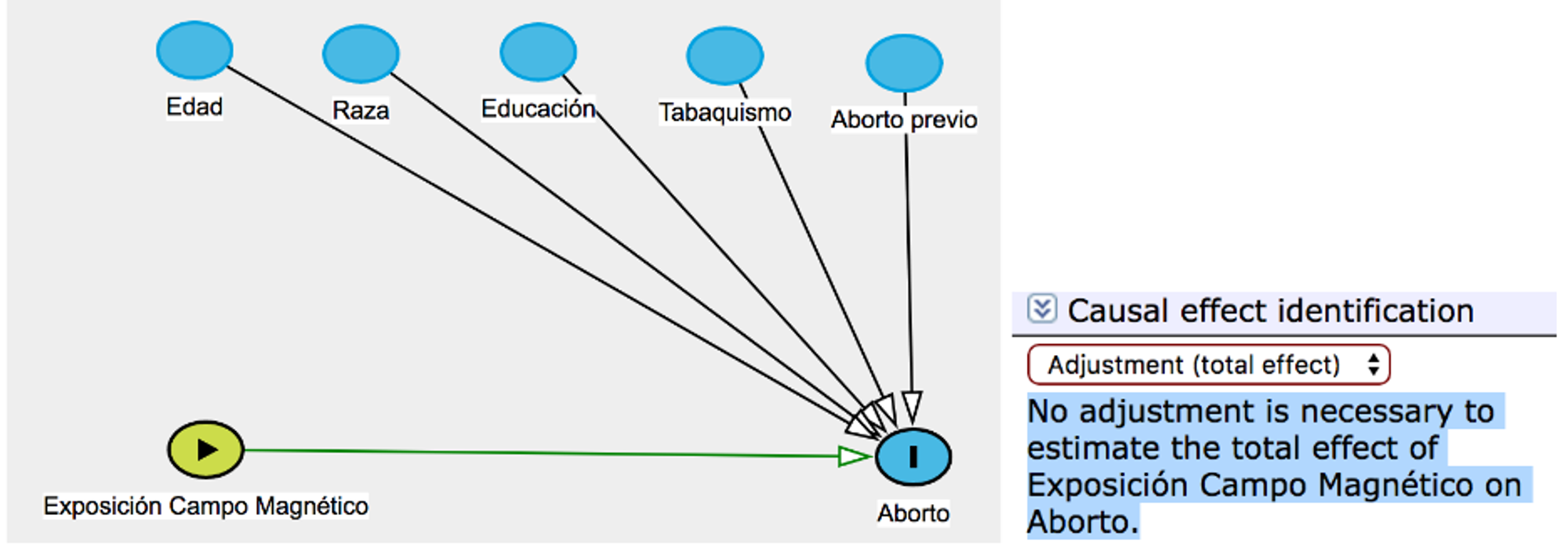

Nos cuentan que en la investigación de la exposición al campo magnético rara vez se presentan variables confundentes . Una variable confundente es aquella que se asocia a la exposición y al efecto y debe ser controlada por el investigador: esto se puede hacer en el diseño de la investigación, restringiendo a los participantes al estudio, o mediante pareo, en el caso de los diseños caso-control, o mediante el análisis de los datos, por ejemplo, incorporar esas variables en los modelos de regresión como variables de ajuste. Pese a esto, de todas formas captarán esos datos.

Analizaron los datos utilizando un modelo de sobrevida basado en riesgos proporcionales de Cox y nos entregan la razón de riesgos o Hazard Ratio. Este modelo asume que el riesgo es proporcional durante todo el período estudiado. Y, bueno, en aborto el riesgo no es proporcional durante la edad de gestación: debieron pensar en eso. Tal vez con los otros modelos de sobrevida no paramétrico no obtenían estos resultados. Pero eso es elucubración. Sigamos.

Nos dicen que midieron a las mujeres solo hasta la edad gestacional 20 y que la mayoría de las variables no son confundentes, pero que las van a incorporar para ajuste en el modelo de Cox de todas formas.

¡¿QUÉ?! ¿Por qué harían eso? ¡Eso se llama sobreajustar y trae consecuencias que pueden sesgar los resultados! Cuando usted sobreajusta un modelo con variables que no debía incorporar, puede crear una «falsa asociación» entre la exposición y el efecto. Es decir, puede modificar el efecto real que estaba midiendo.

Grafo causal del estudio (hecho por nosotros no ve que está en tchileno) Fuente: DAGitty: A Graphical Tool for Analyzing Causal Diagrams

Continuemos, tal vez mejora más adelante.

Los autores nuevamente nos recuerdan que solo medirán «días típicos» y ahora nos dicen que eso se ve afectado por el clima. Pero no explican qué significa esto. Si alguien quisiera replicar este estudio tendría que ir obligadamente a suplicarle al autor que le diga cómo midió estas variables.

Bueno, vamos a los resultados: show me the data

Como somos híper curiosos, metimos los pocos datos que compartieron en el software Stata y, efectivamente, al reclutar a las participantes, los dos grupos a comparar son similares en todas las variables. Eso es genial, ya que con eso se puede adjudicar toda la fuerza de la asociación solo a la variable considerada como «exposición».

No obstante, esto suena muy extraño. Quienes hemos trabajado con grandes bases de datos sabemos que, por azar, muchas veces los grupos a comparar son diferentes en algunas características. Por ejemplo, tienen más personas mayores en uno de los grupos, o más personas de nivel socioeconómico mayor en el otro grupo, etc. Es decir, no siempre encontramos balanceados perfectamente a nuestros grupos en todas las variables al ingresar al estudio.

Bueno... Tuvieron suerte, no seamos tan malpensados.

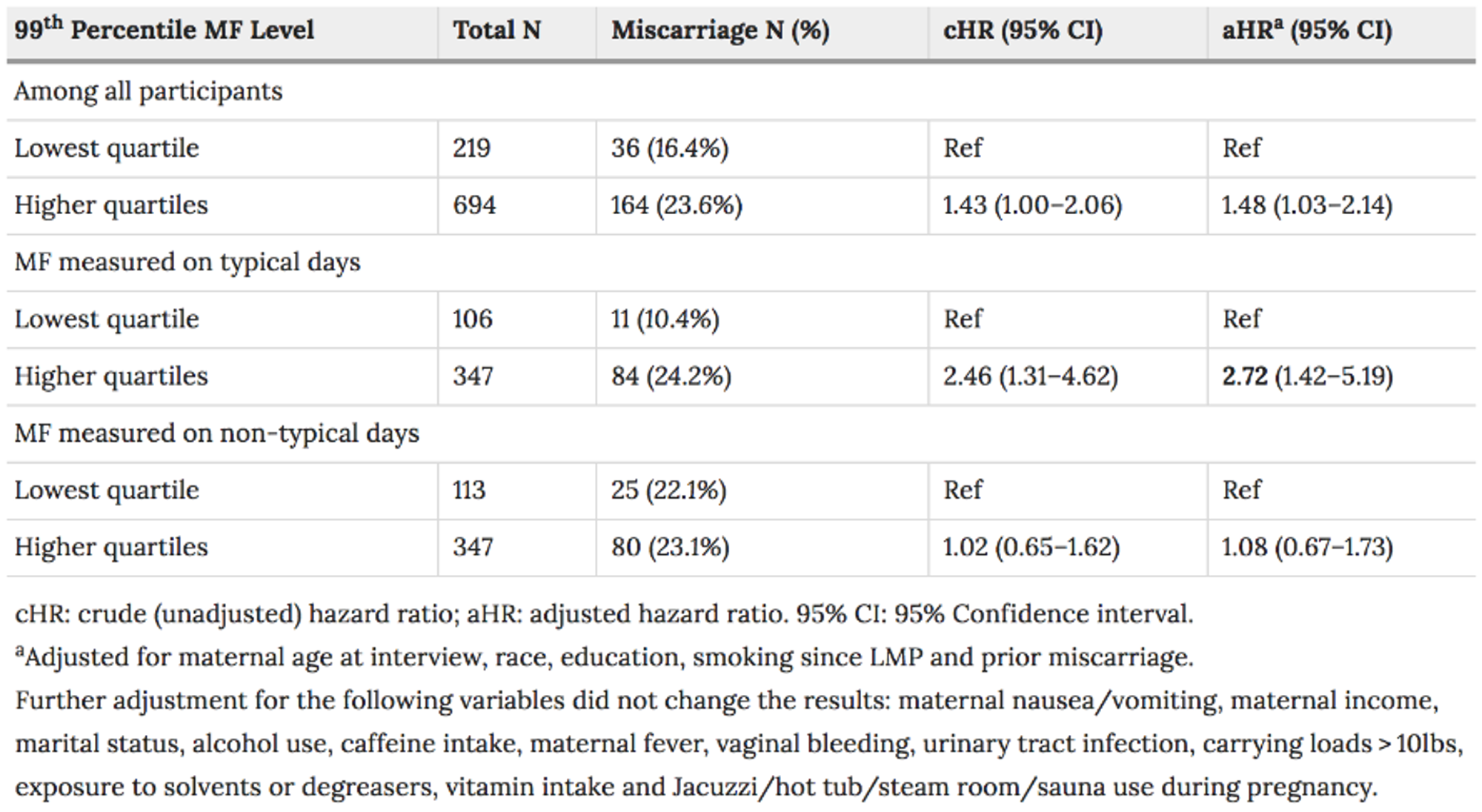

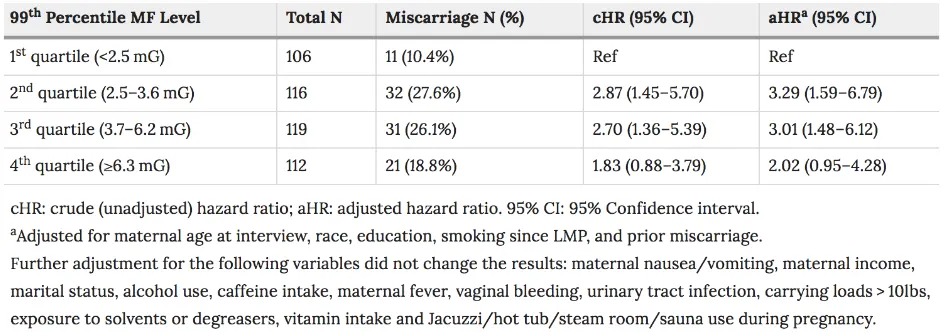

Fuente: Table 2: Exposure to High Magnetic Fields (MFs) During Pregnancy and the Risk of Miscarriage.

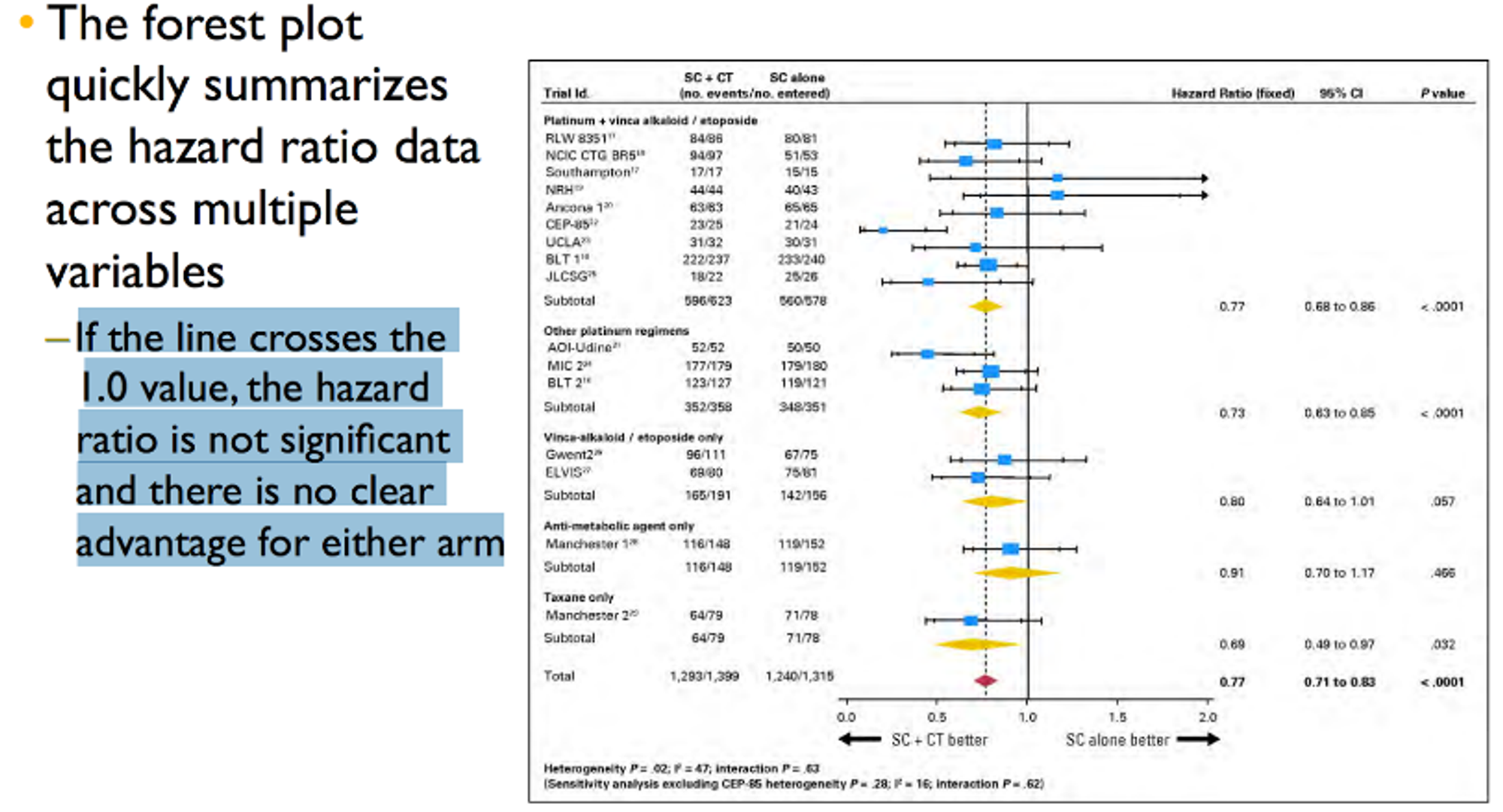

Al analizar la Tabla 2, de donde salen muchas conclusiones, vemos que realmente los hazard ratios reportados no son significativos en el modelo crudo (un modelo crudo no tiene variables de ajuste: solo se modela la exposición y el efecto), o los hazard son marginales, dados sus intervalos de confianza al 95%. En el caso del modelo crudo, el límite inferior del intervalo de confianza pasa por el valor 1 (va del 1,00 al 2,06), lo que indica que, en algún momento, los dos grupos tienen el mismo riesgo: esto hace perder o anula la significancia estadística de la comparación.

En el caso del modelo ajustado (ajustaron por edad, raza, educación, tabaquismo desde la fecha de última regla FUR y abortos previos), el intervalo inferior inicia en 1,03 (va del 1.03 al 2.14). Aunque no pasa por la unidad, 1,03 es casi 1 y debieran haberlo descrito en las limitaciones (especialmente si piensan recomendar que las embarazadas dejen de usar celular o acercarse a fuentes de wifi... Nosotros exigiríamos estimadores con intervalos de confianza más alejados del valor de nulidad).

Acá podemos ver un ejemplo de diversos estudios y sus hazard ratios. Como podemos apreciar en la figura, si el intervalo de confianza cruza el valor 1, el hazard ratio no es significativo y no existe una clara ventaja entre los grupos. Fuente: Understanding Hazard Ratios. Epiphany Partners.

Por cierto, recordemos que de acuerdo a la teoría, no debieron ajustar estos modelos, pero en los resultados se refieren a los datos obtenidos mediante modelos ajustados. Dicen que las mujeres expuestas a estos niveles elevados de campo magnético tienen un aumento de riesgo de aborto del 48%. ¡Pero ese dato solo lo obtienen en los modelos ajustados con un intervalo de confianza que casi pasa por el valor uno! (emoji ojitos arriba). Y, al mirar en los «días típicos», la asociación fue más potente. Pero en los días «no típicos» esta asociación se pierde. Entonces, PAF, sacaron esos datos.

Amablemente, nos comparten la información para todos los cuartiles de exposición a campo magnético, y vemos que en el último cuartil nuevamente el indicador no es significativo, ya que pasa el intervalo de confianza por el valor 1. Entonces nos deja pensando nuevamente por qué habrán decidido esa división que suena tan arbitraria entre cuartil 1 y cuartiles 2+3+4. El tiempo lo dirá (?). Lo positivo es que reconocen que no existe relación dosis/respuesta (también llamado gradiente biológico: significa que la frecuencia de la enfermedad aumenta con la dosis o el nivel de exposición) y es uno de los criterios para determinar causalidad (no es nada al lote). Como podemos ver en la tabla, el riesgo de aborto aumenta en los primeros cuartiles, pero luego cuando llegamos a la máxima exposición, cuando debiéramos encontrar más casos de aborto, tanto los casos como el hazard ratio bajan. Entonces algo no cuadra. ¿No era que la alta exposición al campo magnético causaba los abortos? Según estos datos, un rotundo no.

Al finalizar los resultados, nos dicen que, aunque el instrumento no mide las fuentes de emisión de campos magnéticos, lograron recopilar estos datos desde un diario completado por las participantes. Nos indican que no existieron diferencias en los resultados, que fueron independientes de la fuente emisora o localización.

¿Y entonces lo del wifi o teléfonos de dónde sale?

Tranquilo nervioso, que llegamos a las discusiones. Tal vez ahora se resuelven todas nuestras inquietudes.

Discusiones

Los autores no mencionaron ninguna limitación metodológica en su estudio, solo fortalezas.

En serio.

Solo mencionan que no se observó una relación dosis/respuesta, pero entregan una justificación que es por un posible «efecto umbral», que tampoco explicaron en detalle.

Tampoco indicaron por qué adjudican esas mediciones a las fuentes de emisión de Wifi o telefonía.

Plop.

Entonces, en resumen…

Es un estudio que tiene muchísimas limitaciones metodológicas. Muchas decisiones arbitrarias tomadas sin mayor justificación o explicación por parte de los autores y poquísima transparencia en los datos básicos entregados: esto impide comprender siquiera las variables medidas por los investigadores.

Los autores terminan sugiriendo la existencia de un riesgo aumentado de aborto en embarazadas expuestas a niveles elevados de campo magnético. Pero los datos no muestran eso: si nos fijamos en los datos que realmente nos teníamos que fijar, el modelo crudo no apoya esta aseveración de los autores ni existe una relación dosis/respuesta.

Tampoco se menciona nada de las fuentes de radiación en resultados ni en las discusiones (solo se hace referencia al wifi o telefonía cuando se habla de otro artículo).

Tenemos que recalcar en este punto que no por encontrarse un artículo publicado en una revista de renombre internacional, avalado por una editorial seria, como Nature, lo hace automáticamente bueno o infalible. Cada artículo debe ser analizado profundamente por sus propios méritos, independiente de la revista y su factor de impacto. Inolvidable es el caso del fraudulento artículo publicado por Andrew Wakefield en la prestigiosa revista Lancet y que debió ser retractado, por ejemplo.

Por eso, y considerando los resultados, nos alegra decirle que no hay nada que temer: los datos realmente no apoyan la hipótesis de los autores. Así que puede seguir embarazándose y chatear todo lo que quiera (sería interesante saber si una cosa lleva a la otra… Idea de investigación).

Por último, y si le interesa profundizar en la materia, le contamos que en Etilmercurio ya habíamos hablado de radiaciones no ionizantes, uso de celulares y el cáncer. Acá puede encontrar ese artículo.