Por Catherine Muñoz, Abogada, LL.M. int. Universidad de Heidelberg, consultora especializada en materias relacionadas con innovación, ética, regulación de tecnologías y DDHH.

¿PARA QUIÉN ES LA IA?

Todos hemos escuchado sobre los grandes avances y beneficios de la IA, pero estos avances y beneficios ¿son para todos? Nunca se han preguntado ¿para quién es la inteligencia artificial? ¿a quién realmente beneficia? Quizás es el momento de hacerlo.

Podríamos dejar esta pregunta abierta, dependiendo de tu grado de optimismo, pero lo que sí podemos afirmar es para quien no es.

Usualmente no es para grupos vulnerables, excluidos, marginados, y además en muchos casos probablemente no lo sea para la gran mayoría de nosotros cuando es aplicada para resolver grandes problemas sociales o cuando es ocupado como una herramienta de control o poder, lo cual se evidencia claramente en dos tipos de aplicaciones: los sistemas de reconocimiento facial (RF) y los sistemas de toma de decisiones automatizadas.

1.- LOS SISTEMAS DE RECONOCIMIENTO FACIAL (RF) Y EL REGRESO DE UNA OSCURA Y RECHAZADA PSEUDOCIENCIA.

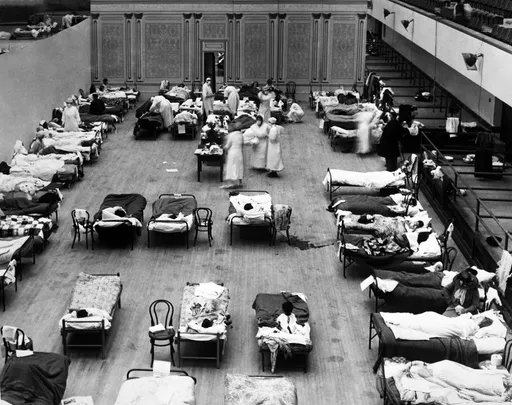

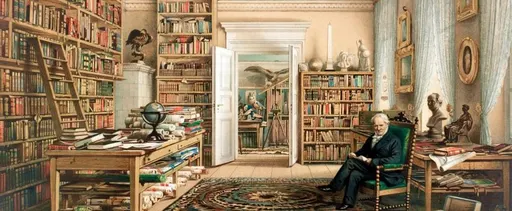

Durante la pandemia se ha incorporado diversos tipos de tecnología a los procesos educativos, generalizando la educación a distancia. Se creó un sistema de IA para reconocer las expresiones faciales de niños descrito como “un sistema con precisión a nivel humano” según una nota de CNN (1). La nota señala que el sistema genera informes sobre fortalezas, debilidades, niveles de motivación y prediciendo calificaciones, siendo muy útil para los profesores durante la pandemia ya que pueden monitorear de forma remota las emociones de sus alumnos.

Por su parte, la empresa israelí Faception (2) ofrece sus servicios de reconocimiento facial para detectar tipos de personalidades, tales como, personas introvertidas, extrovertidos, pedófilos, genios y delincuentes, entre muchas otras características, en base a análisis fotográficos. Esta empresa fue contratada por el gobierno de USA hace algunos años para detectar terroristas. Este tipo de tecnología, es de gran interés para muchas industrias, en particular, las empresas de retail están modernizando sus cámaras “de seguridad” para que puedan detectar las expresiones de sus compradores incorporando sistemas de IA que leen emociones con el objeto de generar estrategias de marketing más efectivas y personalizadas (3).

Servicios ofrecidos por la empresa Faception

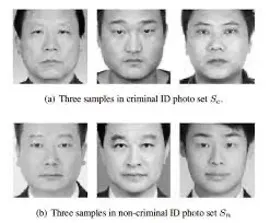

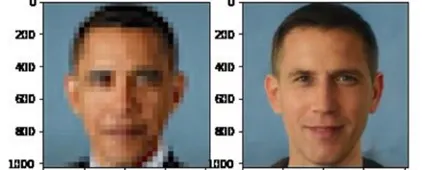

En un estudio muy conocido del año 2016, dos investigadores Wu y Zhang, entrenaron un sistema de IA de machine learning (a través de aprendizaje supervisado) con fotografías de hombres chinos delincuentes proporcionadas por el Estado y fotografías de hombres chinos no delincuentes tomadas de buscadores de internet, la idea era que el sistema detectara hombres chinos delincuentes de otro que no lo eran frente a nuevos datos, caras en este caso, todo para prevenir en definitiva delitos a lo “Minority Report”, la película, bueno ese mismo rollo.

Su experimento comenzó utilizando IA más básicas y luego con el uso de una red neuronal convolucional más avanzada, AlexNet, logrando según indicaron una precisión de clasificación de casi el 90% de hombres delincuentes al procesar imágenes nuevas(4). El resultado era algo como esto:

Lo cierto es que todo lo anterior es una narrativa totalmente exagerada de marketing, existe una brecha gigante entre las expectativas de estas tecnologías y lo que realmente pueden ofrecer.

La realidad es que los sistemas de RF no pueden hacer nada de lo prometido en los casos indicados. Ninguno puede reconocer emociones, extrovertidos, pedófilos ni terroristas, tampoco ha resultado ser un medio efectivo para reducir la delincuencia.

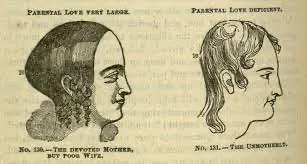

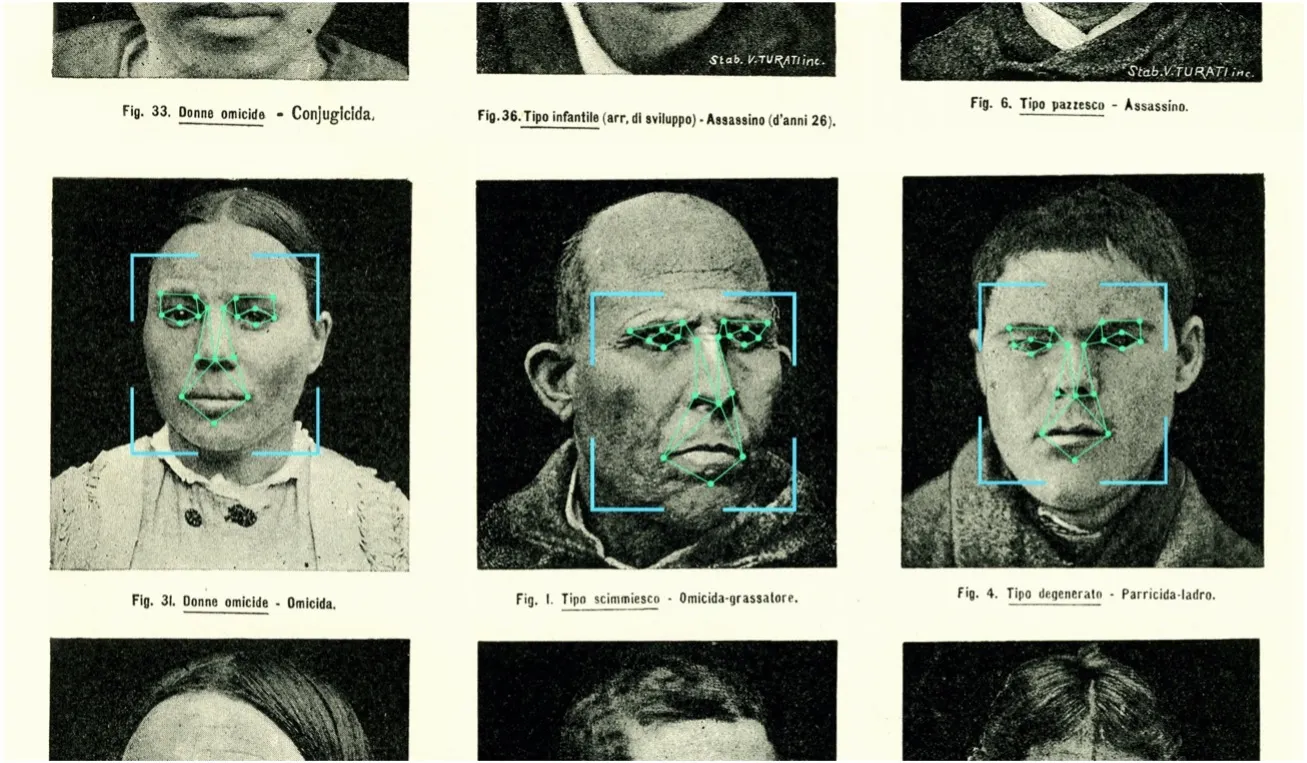

Todo lo anterior es un muy sofisticado disfraz de ciencia que confunde a las personas bajo un velo de veracidad, en definitiva muchos sistemas de este tipo son una moderna forma de reproducir antigua pseudociencia, como las constelaciones familiares, los cursos de eneagrama (si Freud y Jung), y la aberrante frenología craneal del siglo XIX, pero peligrosa porque es de aquellas basada en el racismo.

Y si pudiéramos resumir en una frase qué hace el reconocimiento facial, en los casos descritos podríamos decir que detecta estereotipos basados en frenología y fisonomía antiguas pseudociencias.

Volvimos a esta tontería ¡pero con computadores!

Los estereotipos corresponden a una sobrerrepresentación, un modo de clasificar y definir a un grupo de personas por parte de otro dominante, y que por sí mismo constituyen un acto discriminatorio, usado como fundamento para dominar a grupos vulnerables o históricamente oprimidos, lo usaron españoles en la constitución de la llamada América, los norteamericanos para justificar la permanencia de esclavos, lo usamos actualmente al compararnos con pueblos originarios ¿No lo creen?, hagan una simple prueba, busquen internet imágenes de «hombres chilenos», el resultado que arroja muestra a hombres blancos, sonriendo y posando (no reflejando al común de los hombres chilenos para nada por lo demás) sin ningún contexto en particular. No aparecen alusiones a la cultura, tradición e historia y los botones de búsqueda adicional sugerida son triviales (jóvenes, famosos, normales, actores). Si luego buscan, «hombres mapuches», la mayor parte de las imágenes representan a personas enojadas o confrontaciones caracterizadas por sus vestimentas y dentro de un contexto cultural exacerbado alejado de la modernidad. Lo anterior es un reflejo de cómo socialmente se crean estereotipos definido por un grupo dominante.

Si volvemos al experimento de Wu y Zhang y de las fotos señaladas ustedes probablemente llegarían a las mismas conclusiones sobre cuáles son delincuentes y cuáles no y probablemente estén súper equivocados y estén clasificando a las personas en base a estereotipos, esto es, las personas supuestamente delincuentes están enojadas mientras que las personas “no delincuentes” sonríen, usan traje, entre otras cualidades estereotipadas. También es razonable suponer que las fotografías policiales tomadas en el contexto amenazante y humillante del arresto se ven diferentes de otras tomadas en otro contexto.

Por su parte, las emociones están compuestas simultáneamente por componentes fisiológicos, mentales, psicológicos, culturales y fenomenológicos individualmente subjetivos por lo que no pueden ser reconocidas por sistemas de IA y nuevamente lo único que pueden reconocer son estereotipos que son creados en contextos sociales particulares, por lo que no son en ningún caso predictores de emociones reales.

Estos estereotipos fueron desarrollados por la frenología y fisiognomía, pseudociencias desacreditadas a principios del siglo XX que afirmaban ser capaces de inferir rasgos de carácter o personalidades a partir de características físicas exteriores como la forma y tamaño del cráneo o características de un rostro, con la finalidad de clasificar personas superiores e inferiores.

Evidentemente, estudios posteriores evidenciaron que no existe tal cosa como una “cara criminal” lo cual parece haber sido olvidado e increíblemente ha sido reformulado bajo esta tecnología.

Y SI NO SIRVE PARA NADA, ¿POR QUÉ ES TAN POPULAR EL USO DE SISTEMAS DE RF?

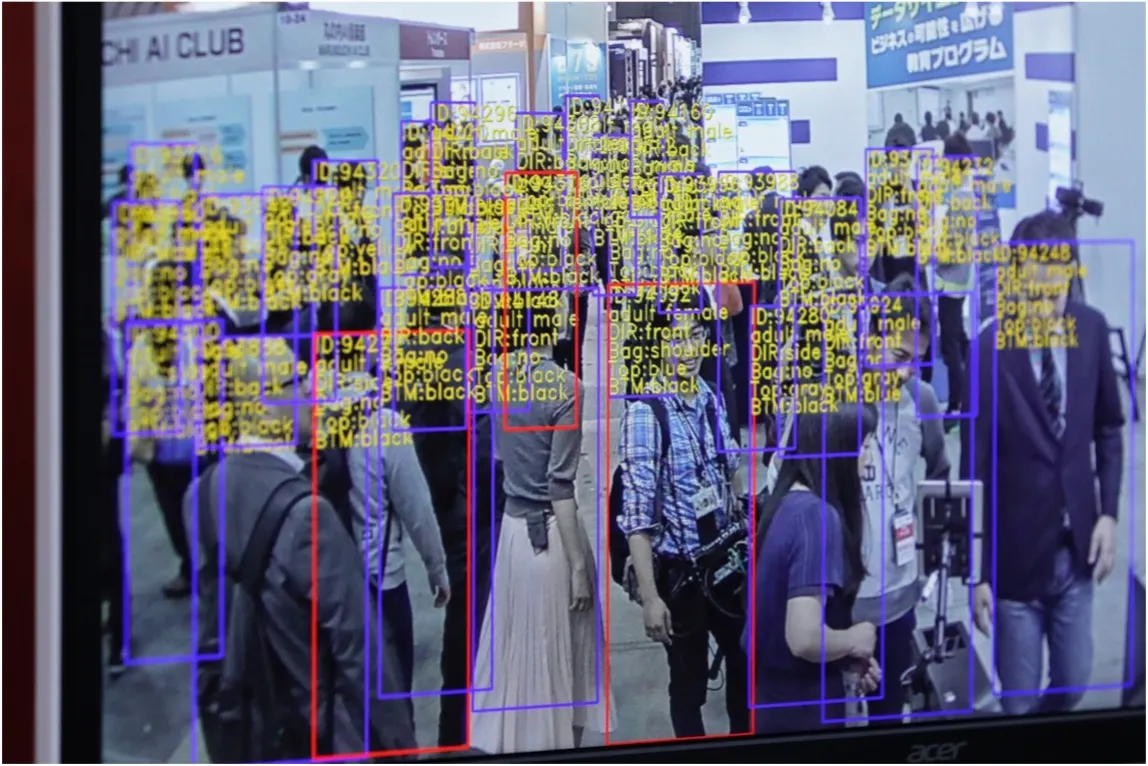

El racismo es una realidad y desde siglos se ha manifestado de diversas formas, una de esta es los sistemas de reconocimiento facial. Además, todas las historias de terror pueden ser aun mas espeluznantes y junto con el uso descrito, el uso más básico y común de los sistemas de RF es el de “reconocer la identidad de las personas”, convirtiéndose en un generalizado mecanismo de vigilancia masiva, usado por muchos países (y privados) con objetivos tan viles como oprimir y controlar migrantes, detractores políticos, inhibiendo derechos como la libertad de expresión, el derecho de reunión y protesta ya que usado en las calles, las personas pierden sin consentimiento, su anonimato y su libertad para protestar.

Ahora, el supuesto anterior ocurre si reconocen bien a una persona, no obstante, estos sistemas poseen una importante tasa de error, lo cual afecta desproporcionadamente a comunidades marginadas.

Así, por ejemplo, muchos de los sistemas de RF para detectar la identidad de personas que son usados alegando fines loables como la prevención de todo tipo de delitos, no funcionan, posee altas tasas de error, ya sea porque están basado en una pseudociencia o por que se basan en datos de entrenamiento carentes de representatividad, datos incompletos, muchos de ellos reflejo de detenciones ilegales y racismo policial, sesgos que pasan a ser parte de estos sistemas, los cuales frente a nuevos datos (caras) estigmatizan, reproducen y amplifican prejuicios sobre grupos históricamente oprimidos y marginados.

2.- LA AUTOMATIZACIÓN DE LA SEGREGACIÓN Y DESIGUALDAD: LOS SISTEMAS DE TOMA DE DECISIONES AUTOMATIZADAS

Si hablamos de estigmatizar, reproducir y amplifican prejuicios sobre grupos históricamente oprimidos y marginados, los sistemas de toma de decisiones automatizadas tienen mucho que decir.

Los sistemas de toma de decisiones automatizadas han existido desde hace décadas (el piloto automático de los aviones), pero hoy en día con el desarrollo del machine learning estos desarrollos han tomado caminos mas ambiciosos, como pretender resolver problemas sociales complejos y usados por muchos gobiernos (y privados) para múltiples propósitos como determinar quién recibe ciertos beneficios, administrar educación y salud pública, determinar quién tiene riesgo de reincidir en un delito o quién tiene riesgo de violencia.

En muchos de estos casos, ha quedado demostrado que este tipo de sistemas aplicado a complejidades sociales, como asignación de calificaciones estudiantiles, predicción de delitos y predicción de abusos infantiles, entre otros, implica un riesgo concreto de reproducción, amplificación y perpetuación de injusticias sociales sobre grupos históricamente excluidos y vulnerables, tales como, pueblos originarios, comunidades LGBTIQ+, minorías religiosas y personas de escasos recursos.

Lo preocupante es que a pesar de la evidencia documentada sobre los impactos negativos de este tipo de tecnología aplicada como servicios públicos, estos han aumentado de forma progresiva, siendo globalmente implementados en diversas áreas bajo políticas de modernización estatal, eficiencia pública y austeridad.

Parte de dicha evidencia documentada:

Luego de múltiples demandas colectivas interpuestas, en el año 2016 la Agencia de Seguro de Desempleo de Michigan, Estados Unidos de América, luego de una revisión, confirmó que había acusado erróneamente a más de 20.000 personas de fraude en la obtención de beneficios de desempleo, lo cual correspondía a mas del 93% de los casos detectados . Con posterioridad en el año 2019 el número de casos confirmados aumentó a 40.000. (5)

La detección de fraudes en el pago de beneficios de desempleo era establecida por un sistema algorítmico de toma de decisiones automatizadas, determinándose que las personas detectadas por el algoritmo debían pagar al Estado 5 veces la cantidad solicitada. Las personas erróneamente afectadas eran notificadas tardíamente por lo que no tenían opción de impugnar la medida, viéndose obligadas a pagar multas elevadas, lo que llevó a que muchas familias fueran llevadas a la quiebra, otras se desintegraron y al menos dos suicidios estuvieron involucrados. (6)

A principios del año 2021, en un hecho sin precedentes el gobierno de los Países Bajos anunció su dimisión en bloque luego de una investigación realizada por el parlamento que concluyó que tanto el Jefe de Estado como sus principales ministros eran culpables de menoscabo institucional y discriminación contra un grupo vulnerable de la población holandesa, luego de detectar que un sistema de inteligencia artificial (IA) de toma de decisiones automatizada había erróneamente detectado fraude en la solicitud de subsidios sociales correspondientes a mantención infantil en al menos 26.000 familias, la gran mayoría de origen marroquíes y tunecinos. Al igual que en el caso anterior, estas falsas acusaciones desencadenaron ruina financiera, depresión, intentos de suicidios y graves problemas de salud en las personas afectadas. (7)

Existen muchos casos recientes, conocidos a propósito de la pandemia del COVID-19 como el sistema que asignó notas de exámenes para entrar a la universidad en el Reino Unido, favoreciendo a estudiantes de mayores ingresos y perjudicando a estudiantes de escasos recursos y los sistemas usados de salud para asignación de gravedad de pacientes, priorización de vacunas, entre otros, que favorecían a personas de mayores ingresos, ya que este tipo de sistemas en materia de salud ha asociado enfermedad con mayores gastos médicos, lo cual no tiene una causalidad real, ya que mayores gastos médicos no significan personas más enfermas, sino personas que tienen mucho dinero para gastar en salud.

Referencias

(1) M. C. Business CNN, «This AI reads children’s emotions as they learn», CNN. https://www.cnn.com/2021/02/16/tech/emotion-recognition-ai-education-spc-intl-hnk/index.html (accedido 19 de enero de 2022).

(2) «FACEPTION | Facial Personality Analytics», faception. https://www.faception.com (accedido 19 de enero de 2022).

(3) J. Rose, «Brands Want To Predict Your Behavior By Mining Your Face From YouTube Videos», Vice, 24 de mayo de 2016. https://www.vice.com/en/article/jpggab/facial-recognition-brands-mattersight (accedido 19 de enero de 2022).

(4) X. Wu y X. Zhang, Automated Inference on Criminality using Face Images. 2016.

(5) Crawford, Kate, and Jason Schultz. "AI systems as state actors." Columbia Law Review

119.7 (2019): 1941-1972.