Las elecciones presidenciales (al menos la primera vuelta) y parlamentarias ya son historia. La prensa, los grupos y analistas políticos se desayunan haciendo lecturas del proceso. En Etilmercurio no quisimos ser menos, así es que nos unimos a esta gran cadena de amor y esperanza (?).

24 mil 500 raya 03... Ah, no. Programa equivocado

En todas partes escuchamos y conversamos sobre quiénes fueron las y los grandes ganadores y perdedores de esta elección. Si bien usted podría decir que el puesto de gran perdedor está más peleado que nunca, aquí tenemos nuestra candidata segura: las encuestas.

El acierto de las encuestas analizadas en los últimos seis meses fue bajísimo (tan bajo, que hasta Aroldo Maciel se ofreció a brindarles asesoría). La caída de las encuestas se dio sobre todo en cómo subestimaron a los candidatos Kast y Sánchez, y sobreestimaron a Piñera.

¿Qué pasó ahí? ¿Hay acá trabajo mal hecho o intenciones políticas en juego? ¿Vale la pena seguir gastando plata en hacer encuestas? En otras palabras, ¿sirven de algo estas famosas mediciones?

Método, método, si quieres hacer algo bien necesitas mucho método

Seguro que todo el mundo ha escuchado a alguien quejarse de que las encuestas no son verdaderas porque «a mí nunca me han encuestado». Si bien este no es el mejor momento para defender las encuestas, debemos decir que esa frase no tiene sentido en lo absoluto. Esto porque una encuesta bien hecha se hace sobre un muestreo probabilístico aleatorio y no aplicando cuestionarios a gente al azar. Resulta que, aunque no lo crea, hay una metodología científica detrás. Y cuando se acaba la metodología, muy probablemente se acaba también el argumento (sospechamos que porque se apareció frente a usted su anatomía).

Explicaremos esto de la manera más sencilla y didáctica posible para que todo el mundo entienda y nadie se quede dormido.

Hace mucho tiempo, en un país lejano, vivía un buen señor llamado Carl F. Gauss. Este buen señor —matemático, astrónomo y físico, entre otros galardones— se dio cuenta de varias cosas, pero la que nos importa ahora es que identificó una distribución de probabilidad en las cuales la moda (valor más repetido), la media (promedio) y la mediana (valor central) coinciden. Esto nos permite modelar una serie de fenómenos naturales, sociales y psicológicos.

La cosa funciona así: los valores centrales del plano suelen acumular la mayor frecuencia y, a medida que nos acercamos a los extremos, esa frecuencia baja. Para entenderlo, pongamos un ejemplo: la estatura de los hombres. Quizás usted diría que la mayor parte de los hombres con los que ha compartido en la vida miden entre 1,70 y 1,80 metros. Y, a medida que nos alejamos de esos valores, la frecuencia baja. Así, cada vez se hace más difícil pensar en algún hombre que conozcamos con una estatura de 1,55 m o menos, o de 1,95 m o más. A esto le llamamos curva de Gauss, curva normal, o distribución normal.

Sí, los alemanes son tan cuadrados que en sus billetes de 10 marcos (¡se llamaban marcos!) tenían a Gauss alzando su ceja (seguramente por lo poco que le creía a las encuestas en Chile).

Desde esta distribución normal explicada por Gauss se desprenden los principios en los que se basa el muestreo estadístico. Aquí las cosas no son al lote: un muestreo probabilístico, es decir, aquel que nos permite extrapolar los resultados a la población, se funda en el Teorema del límite central y en la Ley de los grandes números. El teorema del límite central indica que cuando el tamaño de una muestra es el suficiente, las medias que se obtengan tenderán a comportarse según la curva normal, mientras que la ley de los grandes números dice que a medida que más veces hagamos una prueba (en este caso, una encuesta), los valores obtenidos tenderán a estabilizarse en la probabilidad real.

Si entendimos bien lo anterior, sabremos que no hay forma de tener un 100% de certeza de que la muestra con la que estamos trabajando sea un indicador exacto de la realidad (a menos que la muestra sea igual al total de la población: es decir, un censo), pero sí que tiende a ella. El trabajo consiste en reducir lo más posible el azar y es por ello que se trabaja con un nivel de confianza y un margen de error. Para lograr muestras estadísticamente representativas, se suele trabajar con un 95% de confianza y un 3% a 5% de error máximo admisible. Estos dos valores tienen una razón de ser, no crea que no. ¿Interesado?

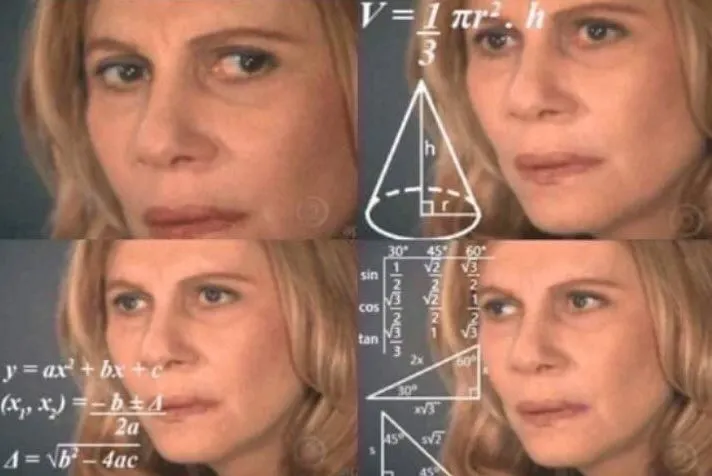

Estudiante promedio de Sociología cuando aprende de muestreo.

El nivel de confianza nunca podrá ser 100%, porque en ese caso sería un censo (que no sea el mejor censo de la historia, por favor). Pero, ¿por qué no 99%? Porque el nivel de confianza también incide en el intervalo de confianza de los resultados. En otras palabras, entre más cercano al 100% es el nivel de confianza, mayor será el rango de los resultados. Por ejemplo, una encuesta arroja que el 8% votaría por candidato A, el intervalo de confianza será más acotado con un 95% de confianza (algo así como de 5% a 11%) mientras que con un 99% sería más amplio (digamos, de 3% a 13%). Por ende, la información que se entrega con mayor confianza es más certera, pero mucho menos precisa.

Con el margen de error pasa algo parecido. Un margen de error mayor a 5% entrega muestras más pequeñas y, por lo tanto, más económicas, pero mucho menos precisas. Por otra parte, un margen de error menor a 3% aumenta demasiado el n total de casos a encuestar (y por ende los costos de la encuesta), pero no se traduce en un aumento importante de la precisión.

Además de tener un nivel de confianza y un error máximo, las encuestas necesitan levantar información. Es decir, ir a terreno y preguntarle a la gente su opinión sobre las cosas (aquí, todos/as somos el encuestador). Para lograrlo, se diseñan tipos de muestreo aleatorios: simples, estratificados o por conglomerados, en donde en cualquiera de estos diseños se debe asegurar que todos los sujetos que componen el universo (es decir, a quienes queremos representar) tengan una probabilidad conocida y distinta de cero de ser elegidos. Entonces, se calcula la muestra total, se establece cómo llegar a las personas y, finalmente, se va a terreno para aplicar las encuestas.

Y si todo es tan científico, ¿por qué andaban tan perdidas las encuestas?

Todo lo que desarrollamos anteriormente habla de la teoría del muestreo, es decir de cómo deberían hacerse las encuestas. Sin embargo, sabemos que del dicho al hecho hay mucho trecho y que las cosas no siempre se hacen de la manera más prolija posible. Entonces, para que una encuesta esté bien hecha, debería cumplir con al menos estos puntos:

1.

Considerar un universo/población encuesta delimitado. Es decir, a quién busca representar. Debe aclarar si es solo Santiago, solo algunas regiones, solo zonas urbanas, etc.

2.

Asegurar un diseño probabilístico. Es decir, que tenga margen de error, nivel de confianza, error máximo admisible y que detalle el tipo de muestreo usado (estratificado, conglomerado o simple). Si usa un muestreo por cuotas, esa encuesta NO es representativa.

3.

Explicar cómo se llevó a cabo el terreno. En general, para que una encuesta sea fiable debe ser aplicada a hogares. Es decir, el encuestador o encuestadora debe ir a la casa de la persona a hacerle las preguntas. Las encuestas telefónicas (sobre todo las que se hacen a teléfonos fijos) se encuentran hace años siendo cuestionadas, aunque ahora se busca complementar teléfonos fijos con celulares.

Ahora, veamos cómo se comportaron las encuestas más populares entre la prensa:

Show All

Si todo lo dicho hasta ahora ha quedado relativamente claro (y si no, nos puede trollear con libertad), resulta evidente que la encuesta Cadem no cumple con los requisitos mínimos de representatividad, porque tiene una muestra que es en parte aleatoria y en parte no. Y como es de público conocimiento, negativo más positivo da negativo, por ende esta encuesta no es representativa. En otras palabras: usted podría tomar la guía telefónica (carné al suelo y con escándalo), llamar a 1.441 personas al azar para hacerles las mismas preguntas de la Cadem y, estadísticamente hablando, sería lo mismo: no representa a la población que dice.

En la Cadem, además, se tienen dos submuestras: una de 1.019 telefónicas y 422 cara a cara. Las encuestas cara a cara son en puntos de afluencia pública de distintas ciudades de Chile y, por ende, todas las probabilidades de le seleccionen para la encuesta se ven distorsionadas por el hecho de andar caminando en tales puntos. Por su parte, las entrevistas telefónicas fueron por cuotas. Es decir, se necesitaban X cantidad de mujeres ABC1 de Talca, Y cantidad de mujeres C3 de Talca, y así sucesivamente, y la idea era ir llenando estas cuotas. Suena desprolijo porque lo es.

La CERC-MORI por su parte, no entrega tanta información sobre su muestreo. Esta encuesta tiene la ventaja de que el cuestionario se aplica cara a cara, por ende va al hogar de las personas y —asumimos— elige aleatoriamente quién responde (para eso se usa una tabla llamada tabla de Kish, que nada tiene que ver con la onda kitsch). En el informe detallan que el muestreo es probabilístico estratificado con afijación proporcional, pero no especifica qué estratos están considerando (pueden ser las cuadras, las comunas, el NSE, o cualquier otra variable que genere grupos homogéneos), así como tampoco especifica el nivel de confianza.

Otro problema que tiene esta encuesta es que se menciona que los casos son 1.200 exactos. Esto es muy anormal en cualquier muestreo. Los números redondos suelen implicar dos cosas: o un reemplazo de los casos, el que no está especificado en la ficha metodológica, o bien un muestreo por cuotas, en donde por ende se perdería el carácter probabilístico del proceso.

La CEP es la encuesta que presenta el mejor muestreo de las tres analizadas, ya que realiza un muestreo probabilístico estratificado por región y zona urbana/rural, y en tres etapas de selección aleatoria: manzana, hogar, entrevistado. Además, no hubo reemplazo de casos. Aquí es posible asegurar que existe un 95% y un error muestral de 3%.

Ahora que ya sabemos cómo se hicieron cada una de las encuestas, veamos cómo anduvieron en su predicción (todos los cálculos con voto probable):

Show All

Como vemos, las encuestas no anduvieron muy cerca, ya que se observan serios problemas de predicción para los tres principales candidatos a la presidencia. No es tarea nuestra pensar en qué intereses políticos estuvieron en juego acá, sino que nos limitamos a ver los problemas técnicos que cada encuesta presenta.

Ya vimos que el diseño de la muestra de las encuestas presenta criterios muy dispares. Además de eso, cada encuesta realizó su propio cálculo para determinar si el votante iba o no a ir a votar, el llamado «voto probable». Claramente, el resultado no fue el óptimo. Por ejemplo, la encuesta CEP es la que presenta el mejor muestreo y en su estimación calcularon que los votantes probables fluctuarían entre 5,9 y 6,7 millones. Finalmente, el electorado total fue de 6.700.748. Cerca, pero al límite. El cálculo del votante probable aparece así como un nuevo aspecto a discutir entre quienes se dedican a este tipo de estudios.

Seguir haciendo encuestas o dejarlas en el olvido, ¿qué opina usted?

El hecho que las predicciones electorales realizadas para la primera vuelta presidencial fallaran no necesariamente significa que las encuestas sean un instrumento del demonio. Por ejemplo, en Francia, donde hay voto voluntario, lograron predecir correctamente la segunda vuelta presidencial y el triunfo de Macron con una alta precisión (algunos datos en el siguiente vínculo). El problema no está en el instrumento como tal, sino en el diseño deficiente y en el uso incorrecto que se le da por parte de las mismas consultoras o de los medios de comunicación.

Es necesario, por lo tanto, que los medios de comunicación y la opinión pública en general revise la prolijidad de los estudios antes de considerar los resultados de los mismos. Esta recomendación la entregamos en relación a todas las encuestas, no solo a las relacionadas con las elecciones (en salud, por ejemplo, basamos muchas políticas públicas en encuestas poblacionales). Entendemos que para la prensa es más llamativo titular con los resultados del estudio que realizar una revisión exhaustiva de la metodología, pero si esta información se pasa por alto, se da cabida a todo tipo de estudios. Además, el llamado es también a revisar cómo se plantean las preguntas en los cuestionarios, ya que no es lo mismo interrogar sobre quién quiere, quién cree, quién piensa, quién le gustaría que fuese Presidente o por quién va a votar en las próximas elecciones. Tampoco da lo mismo si se hacen preguntas abiertas (mención espontánea) o cerradas (con un listado de alternativas).

Para terminar, les contamos que la Cadem sacó el lunes 27 de noviembre su primer sondeo de cara a la segunda vuelta. Revise usted el muestreo y luego hablamos.

Referencias

1.

García Ferrando M. Socioestadística: introducción a la estadística en sociología. Madrid: Alianza Editorial; 2003.

2.

Vivanco M. Muestreo estadístico: diseño y análisis. Santiago de Chile: Editorial Universitaria.

3.

CDC-Centros para el Control y la Prevención de Enfermedades. Toolkit de Encuestas de Salud Reproductiva [Internet]. [citado 29 de noviembre de 2017]. Disponible en: https://www.cdc.gov/Spanish/EncuestasSR/index.html